PERCHE’ le DONNE vengono SPINTE giù dalla SCOGLIERA di VETRO…

Non lasciatevi ingannare dal nome poetico, quasi romantico, di un fenomeno frequente ma di cui si parla poco, troppo poco: il glass cliff o scogliera di cristallo. Che attanaglia le donne al comando in ambienti tradizionalmente appannaggio degli uomini.

Se una volta l’incubo delle donne in carriera di chiamava glass ceiling (soffitto di vetro), quelle situazioni lavorative in cui l’avanzamento di carriera viene impedito per discriminazioni (in genere di carattere razziale o sessuale), oggi l’ostacolo peggiore è il glass cliff (scogliera di vetro).

Coniato da Michelle Ryan e Alex Haslam dell’Università di Exeter, nel 2004, il termine indica la situazione in cui si trovano quelle donne che, pur avendo successo in ruoli tradizionalmente maschili, sono più a rischio di perdere il lavoro e di essere giudicate più severamente o meno competenti dei colleghi maschi, di fronte allo stesso errore.

Come dimostra lo studio dell’Università di Yale “How Won and Easily Lost” che ha analizzato come sono state percepite le decisioni del capo della polizia, prese durante una rissa in una manifestazione. Quando il numero di agenti inviati sul posto era inferiore rispetto la portata degli scontri, se il capo era donna veniva giudicata molto più severamente rispetto se al comando c’era un collega uomo e malgrado i due avessero commesso lo stesso errore.

Lo studio di Yale ha preso in esame anche altre occupazioni: nell’ingegneria aerospaziale e in qualità di giudice supremo. Va riconosciuto che l’effetto non risparmia gli uomini: quando sono chiamati a fare lavori tradizionalmente femminili le conclusioni sono risultate le stesse.

Entriamo nel dettaglio.

COS’È L’EFFETTO SCOGLIERA DI VETRO?

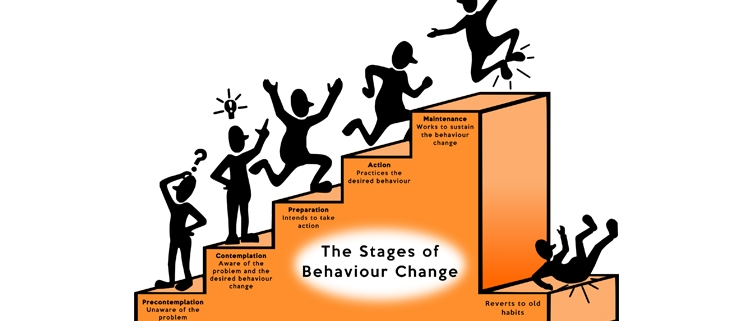

L’effetto Glass Cliff è un fenomeno che descrive la tendenza delle donne a ricoprire posizioni di leadership durante periodi di crisi o quando c’è un alto rischio di fallimento. Questo concetto si basa sull’idea che le donne sono considerate più brave nel trattare con le persone e vengono quindi messe alla guida quando c’è bisogno di un approccio empatico o educativo. Tuttavia, ciò significa anche che le donne hanno maggiori probabilità di fallire, poiché spesso vengono loro affidate le redini quando le cose stanno già andando male.

Ciò suggerisce che le donne sono spesso viste come “ultima risorsa” e vengono coinvolte per cercare di cambiare la situazione.

Altri studi hanno confermato l’esistenza dell’effetto Glass Cliff in vari contesti. Una ricerca sulle elezioni politiche nel Regno Unito ha rilevato che le donne avevano maggiori probabilità di essere selezionate come candidate in seggi impossibili da vincere, mentre gli uomini avevano maggiori probabilità di essere selezionati in seggi considerati sicuri. Ciò suggerisce che le donne vengono spesso messe in posizioni in cui il successo è improbabile e hanno quindi maggiori probabilità di sperimentare il fallimento.

LE RAGIONI DEL GLASS CLIFF

Le donne sono spesso viste come più premurose ed empatiche, e quindi si ritiene siano più brave a trattare con le persone. Ciò può renderle una buona scelta per posizioni di leadership in cui è necessario un approccio collaborativo. Tuttavia, ciò può anche significare che sono considerate meno competenti quando si tratta di competenze difficili come la finanza o la strategia. Ciò significa che hanno maggiori probabilità di venir criticate rispetto agli uomini, il che può rendere loro più difficile il successo. Uno studio condotto su CEO donne ha rilevato che avevano maggiori probabilità di essere prese di mira da investitori attivisti rispetto agli AD uomini.

NATURA DI GENERE E ASSUNZIONE DI RISCHI

La leadership e l’assunzione di rischi sono stati a lungo associati alla mascolinità. Gli uomini sono spesso visti come leader naturali e amanti del rischio, mentre le donne come più avverse al rischio e meno propense ad assumere posizioni di leadership. Questa percezione di genere ha portato le donne a essere sottorappresentate nelle posizioni di comando e a essere trascurate per opportunità ad alto rischio e ad alto rendimento. Tuttavia, recenti ricerche hanno dimostrato che le donne:

– Non sono intrinsecamente avverse al rischio; sono semplicemente più caute quando si tratta di potenziali perdite.

– Hanno maggiori probabilità di essere nominate in posizioni di comando in tempi di crisi o situazioni ad alto rischio perché meglio attrezzate per gestire tali contesti e migliori problem solvers. Ciò significa però che le probabilità di fallire sono maggiori.

– Quando vengono nominate in posizioni di leadership durante una crisi, ricevono meno sostegno e risorse rispetto ai colleghi maschi. Ciò rende loro più difficile avere successo e può far sì che il loro fallimento venga visto come una prova del fatto che non siano efficaci in quel ruolo.

CASI ECLATANTI

La letteratura ha dimostrato che le donne in posizioni di comando durante i periodi di crisi sono spesso destinate al fallimento, poiché le sfide da affrontare sono più complesse.

Nel 2003, Carly Fiorina divenne AD di Hewlett-Packard. È stata la prima donna a guidare un’azienda Fortune 20, ma il suo mandato è stato segnato da forti polemiche e alla fine si è concluso con il licenziamento. La sua nomina è arrivata in un momento in cui HP stava affrontando un calo delle vendite e dei profitti e le è stato affidato il compito di risanare l’azienda.

Nel 2014, Marissa Mayer ha preso il timone di Yahoo, che faticava a competere con Google e Facebook. È stata acclamata come una salvatrice per l’azienda, ma il suo mandato è stato segnato da polemiche. Nonostante gli sforzi per risanare l’azienda, alla fine è stata rimossa dalla posizione.

Theresa May, Primo Ministro del Regno Unito nel 2016. Le è stato affidato il compito di guidare il Paese attraverso uno dei periodi più difficili della sua storia. Nonostante i suoi sforzi per negoziare un accordo sulla Brexit, la sua leadership è stata criticata e alla fine è stata costretta a dimettersi.

L’IMPORTANZA DI UN CAMBIAMENTO ORGANIZZATIVO

La necessità di un cambiamento organizzativo è un aspetto cruciale che non può essere ignorato quando si parla dell’effetto scogliera di vetro. Nelle situazioni di crisi l’organizzazione è già in una posizione vulnerabile e ci si aspetta che il leader cambi la situazione. La pressione per avere successo è elevata e le conseguenze del fallimento sono disastrose.

Per cominciare, le aziende devono riconoscere il valore della diversità e dell’inclusione. Ciò significa che alle donne dovrebbero essere assegnati ruoli di leadership sia nei momenti buoni sia in quelli cattivi, non solo quando un’azienda è in crisi. Significa anche che le donne dovrebbero avere le stesse opportunità di avanzamento degli uomini.

Le donne devono essere sostenute e guidate durante tutta la loro carriera. Ciò può essere fatto attraverso programmi formali di mentoring o creando una cultura in cui le donne sono incoraggiate a cercare mentori e sponsor.

Le aziende devono affrontare le questioni sistemiche che contribuiscono all’effetto glass cliff. Ciò include la lotta ai pregiudizi nelle decisioni di assunzione e promozione, nonché la creazione di una cultura che supporti l’equilibrio tra lavoro e vita privata. Di fatto per andare oltre al glass cliff è importante riconoscere che non è solo responsabilità delle donne. Anche gli uomini svolgono un ruolo fondamentale nella creazione di un contesto lavorativo più equo. E dovrebbero essere incoraggiati a essere alleati nella lotta per l’uguaglianza di genere.

Insomma, il discorso è ampio. Parlarne, affrontarlo apertamente è il primo passo. Anzichè guardare dall’altra parte…